Awalnya blog saya ini sudah diindeks oleh google selama kurang lebih 7 tahun dimulai dari tahun 2008 saya ngeblog. Karena saat itu saya hanya iseng-iseng saja buatnya, jadi isi blognya tidak relevan dengan apa yang saya tulis. Domainnya http://yanwarpro.blogspot.com tetapi isinya tentang cover dokumen. Akhirnya beberapa tahun yang lalu blog ini saya eksport dan duplikat. File saya eksport semua ke blog saya yang baru (http://coverdocument.blogspot.com). Isi dan kontennya sama persis, hanya nama domainnya yang beda. Setelah selesai itu, blog ini saya tinggalkan sampai beberapa tahun tidak terurus, namun masih memberikan trafik sekitar 30-150 uv/day.

Hari ini, blog ini saya perbarui kontennya, yang semula membahas cover dokumen sekarang membahas yang lebih keren sedikit, yaitu "Cara Membuat Blog yang Benar". Saya berpikir, saya dikenal lewat dunia maya dari nama blog saya ini nantinya. Yang dulu hanyalah sebagai graphic designer biasa, sekarang menjadi membahas SEO. Ini lebih menantang dan akan dikenal lebih baik daripada tahun-tahun sebelumnya. Harapan saya seperti itu.

Kembali kepada topik "Memblokir Halaman Situs dengan Robots".

Perlu diketahui bahwa googlebot mengindeks halaman web yang pertama kali dibaca adalah:

1. Robots.txt - nya. Biasanya file ini terletak di root utama server. Misal URL saya http://yanwarpro.blogpsot.com maka robotnya ada di http://yanwarpro.blogspot.com/robots.txt.

Kemudian googlebot mengindeks meta pada halaman web, baru kemudian

2. Meta Content. Perlu diingat juga bahwa di meta juga ada robotnya seperti ini: .

Misalkan ada 2 robot di dalam web, maka yang akan diutamakan adalah yang ada di robots.txt daripada di meta content.

Googlebot bekerja dengan 2 cara, yaitu perayapan dan pengindekan.

1. Perayapan itu sekedar membaca konten pada web kita namun tidak diindeks olehnya. Jadi halaman kita tidak muncul di SERP jika kita mencarinya.

2. Pengindekan bisa dilakukan googlebot tanpa harus melalui perayapan. Jadi web kita bisa muncul di SERP tanpa harus membaca konten di dalamnya terlebih dahulu. Misalkan robot di setting untuk User-Agen Googlebot tidak mengindeks halaman tertentu, maka halaman itu tidak muncul di SERP tanpa menghitung lagi isi di dalamnya untuk masuk dalam perhitungan pengindekan mereka.

Defaulnya, semua web kita itu bisa diindeks oleh mesin pencari, tapi gunanya robot disini untuk membatasi pencarian tertentu.

Untuk belajar mengenai bagaimana perilaku robots google kalian bisa baca artikel tentang ujicoba robots google.

Di bawah ini saya sedang memblokir halaman di blog ini yang dulu sempat diindeks mesin pencari, karena halamanya tidak saya publish lagi, namun sudah saya pindahkan ke draft. Mengapa tidak dihapus saja? Menurut saya tidak perlu, soalnya saya sudah berkorban banyak waktu untuk membuat postingannya.

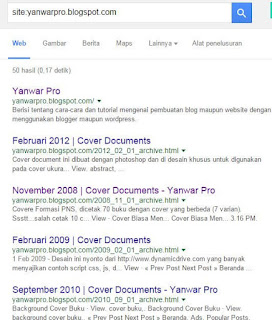

Di blog saya ini sebelumnya sudah terindeks sebanyak 50 halaman termasuk 4 halaman terbaru saya saat ini. Untuk memblokirnya, saya harus memakai robots.txt yang ada di setelan > prefferensi penelusuran.

Update.

Setelah saya tunggu akhirnya pada hari ini tanggal 21 September 2015 postingan saya mulai tahun 2008 sampai 2014 sudah tidak ada di google. Ini saya ketahui dengan search di google.com dengan keyword yanwarpro.blogspot.com, dan hasilnya hanya muncul postingan terbaru saja.

Kenapa saya melakukan hal ini,karena saya ingin membangun blog saya ini lebih besar lagi dari sekarang dan untuk pembahasan cover dokumen sudah saya alihkan. Apakah trafiknya tidak hilang? Alhamdulillah, semua trafik sudah diambil blog saya yang baru.

Jika ingin melihat archive blog saya yang terdahulu, itu bisa dilakukan dengan mengakses http://archive.org/web/ dan ketik yanwarpro.blogspot.com.

Di bawah ini saya sedang memblokir halaman di blog ini yang dulu sempat diindeks mesin pencari, karena halamanya tidak saya publish lagi, namun sudah saya pindahkan ke draft. Mengapa tidak dihapus saja? Menurut saya tidak perlu, soalnya saya sudah berkorban banyak waktu untuk membuat postingannya.

Di blog saya ini sebelumnya sudah terindeks sebanyak 50 halaman termasuk 4 halaman terbaru saya saat ini. Untuk memblokirnya, saya harus memakai robots.txt yang ada di setelan > prefferensi penelusuran.

Masukkan script berikut di robots.txt khusus kemudian simpan. Sebelumnya tes dulu script ini di search console > perayapan > penguji robot teks.

User-agent: Mediapartners-GoogleTunggu beberapa waktu, minimal 24 jam untuk melihat hasilnya di SERP dengan mengakses google.com > site:yanwarpro.blogpspot.com. Kita bisa lihat disitu, berhasil atau tidaknya halaman yang saya maksud untuk diblokir.

Disallow: User-agent: *

Disallow: /search Disallow: /2008

Disallow: /2009

Disallow: /2010

Disallow: /2011

Disallow: /2012

Disallow: /2013

Disallow: /2014

#prevent from duplicate content

Allow: /*.html$

Disallow: /*.html

Sitemap: http://yanwarpro.blogspot.com/sitemap.xml

Update.

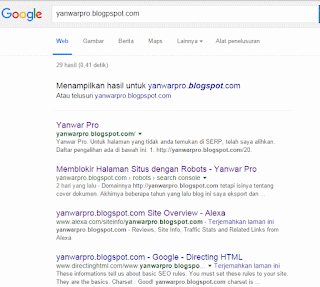

Setelah saya tunggu akhirnya pada hari ini tanggal 21 September 2015 postingan saya mulai tahun 2008 sampai 2014 sudah tidak ada di google. Ini saya ketahui dengan search di google.com dengan keyword yanwarpro.blogspot.com, dan hasilnya hanya muncul postingan terbaru saja.

Kenapa saya melakukan hal ini,karena saya ingin membangun blog saya ini lebih besar lagi dari sekarang dan untuk pembahasan cover dokumen sudah saya alihkan. Apakah trafiknya tidak hilang? Alhamdulillah, semua trafik sudah diambil blog saya yang baru.

Jika ingin melihat archive blog saya yang terdahulu, itu bisa dilakukan dengan mengakses http://archive.org/web/ dan ketik yanwarpro.blogspot.com.